2030. Czy sztuczna inteligencja może być etyczna? Raport Pew Research Center

O cyfryzacji i automatyzacji mówi się w przestrzeni publicznej coraz częściej, także w Polsce, zazwyczaj w kontekście rynku pracy. Choć fizyczne zastępowanie człowieka w jego czynnościach budzi największe emocje, jest tylko jednym z aspektów rozwoju sztucznej inteligencji. Znacznie ważniejsze dla przyszłego kształtu naszej codzienności jest zjawisko rosnącego dostępu przeciętnego człowieka do zaawansowanych technologii. Dotyczy to zarówno coraz intensywniejszego korzystania z urządzeń i usług zależnych od algorytmów, jak i coraz powszechniejszego udziału osób niewyspecjalizowanych w ich tworzeniu.

Eksperci coraz częściej wyrażają zaniepokojenie długofalowym wpływem i konsekwencjami obecności algorytmów, uczenia maszynowego i sztucznej inteligencji w naszej rzeczywistości oraz etycznymi aspektami tej dziedziny. Wyrazem tego trendu jest omawiany tu raport stworzony przez Pew Research Center.

Nowoczesne technologie rozwijane są przede wszystkim przez biznes prywatny, a inwestycje w poszczególne rozwiązania zależne są od motywacji inwestorów. Nakłady państw w sektorze BiR od dekad pozostają wielokrotnie mniejsze niż podmiotów pozarządowych. Wobec braku regulacji branży – technologie są coraz częściej zależne od opłacalności i potencjału komercyjnego, bez uwzględnienia interesu publicznego, długofalowego wpływu na społeczeństwo czy dobrostan jednostek.

Coraz powszechniej pojawiają się pytania o dobro wspólne, o to, co znaczy „być człowiekiem”, być użytecznym i niezależnym, jak powinniśmy rozumieć wolność i prywatność, w jakim stopniu będziemy mogli w przyszłości kierować się wolną wolą. Choć podobne dylematy wydają się domeną filozofów – w kontekście technologii mających gigantyczny potencjał zmiany społecznej nie należy ich ignorować. Namysł nad podobnymi kwestiami powinien decydować o priorytetach i zasadach etycznego projektowania sztucznej inteligencji. AI znajduje bowiem coraz więcej zastosowań nie tylko w gospodarce czy rozrywce, lecz także ma wpływ na politykę, zdrowie, pracę. A przede wszystkim – za pośrednictwem urządzeń osobistych i mediów społecznościowych – na to, jak odbieramy i postrzegamy świat. Nakłady firm i rządów na rozwój przemysłu 4.0 rosną, coraz łatwiejszy jest także dostęp do wykorzystania AI przez niewyspecjalizowanych twórców i użytkowników.

Raport omawiany w tym tekście jest odpowiedzią na coraz powszechniejsze wątpliwości i zainteresowanie konsekwencjami demokratyzacji technologii oraz cyfryzacji naszego życia. W środowiskach eksperckich nieustannie rozwija się refleksja nad tymi zagadnieniami, podejmowane są także działania na rzecz świadomego społecznie i etycznego projektowania sztucznej inteligencji. W badaniu Pew Research Center oraz Imagining the Internet Center ekspertów zapytano o to, jakie będą stan i konsekwencje tych wysiłków w 2030 roku.

O badaniu i raporcie

Raport pt. „Experts Doubt Ethical AI Design Will Be Broadly Adopted as the Norm Within the Next Decade” został stworzony przez ośrodek Pew Research Center oraz Imagining the Internet Center, jednostkę naukową przy Uniwersytecie w Elon w Północnej Karolinie. W badaniu udział wzięły 602 osoby – innowatorzy i deweloperzy technologii, liderzy biznesu i legislatorzy, badacze i aktywiści działający w polu nowoczesnych technologii.

Co istotne dla wyników badania, odpowiedzi zbierane były latem 2020 roku w Stanach Zjednoczonych. A zatem w okolicznościach związanych z pandemią SARS-CoV-2; przed tym, jak zarejestrowano którąkolwiek szczepionkę na covid-19; w czasie wzmożenia społecznego związanego z równością rasową i sprawiedliwością społeczną oraz w kampanii wyborczej przed wyborami prezydenckimi.

Wnioski: Trudno spodziewać się pozytywnych rozwiązań bez naruszenia status quo

Główne pytanie badania dotyczyło tego, czy „w roku 2030 większość rozwiązań AI, stosowanych we wszelkiego rodzaju organizacjach, będzie funkcjonować zgodnie z etycznymi zasadami służącym przede wszystkim dobru wspólnemu”. 68 procent badanych ekspertów odpowiedziało, że takie standardy nie będą wtedy obowiązywać. Pozostałe 32 procent, które udzieliło odpowiedzi, wykazało się optymizmem i odpowiedziało: tak, będą obowiązywać. Dalsza część badania polegała na rozwijaniu przez ekspertów ich odpowiedzi na to pierwotne pytanie – poproszono o komentarze i uzasadnienia, pytano o nadzieje oraz niepokoje i wątpliwości związane z dalszym rozwojem sztucznej inteligencji.

Na pytanie zadane w badaniu odpowiada również KACPER NOSARZEWSKI, Partner w firmie 4CF i ekspert PTSP.

|

W rozwinięciach swoich odpowiedzi eksperci opowiadali o swoich założeniach, doświadczeniach i wnioskach dotyczących dylematów etycznych w projektowaniu AI oraz rozwoju samej dziedziny.

Wyrażali przekonanie, że niezależnie od tego, z jakim zaangażowaniem i wnikliwością problem ten będzie konfrontowany, rozwiązania będą tylko częściowe i o ograniczonej skuteczności. Wskazywano jednak, iż bez względu na skuteczność formułowania i przestrzegania standardów etycznych, zgodnie z którymi miałyby działać algorytmy, sztuczna inteligencja ze swej natury jest w większym stopniu niż ludzie zdolna do formułowania etycznych sądów niezależnych od emocji. Co za tym idzie – AI jest bardziej obiektywna i wolna od namiętności, którym ulegają ludzie. Oczywiście mimo tego zastrzeżenia, jednym z głównych zagrożeń identyfikowanych przez ekspertów jest to, że uczenie maszynowe, programowane na początkowym etapie przez ludzi, może reprodukować (w niewyobrażalnej skali) warunkowane kulturowo wzory dyskryminacji. Na tym właśnie może polegać potencjalne zło, które może wymknąć się spod kontroli – sztuczna inteligencja może ugruntowywać niesprawiedliwość, zamiast jej przeciwdziałać bądź ją niwelować. Zdaniem ekspertów nie można zatem cedować decyzji dotyczących losu ludzi na systemy sztucznej inteligencji – i konieczne są tu pewne obostrzenia.

W stanowiskach ekspertów pojawił się także kontekst polityki globalnej. Jedna z najpopularniejszych na świecie osób zajmujących się foresightem – Amy Webb, w swojej wypowiedzi zwróciła uwagę na znaczenie Chin i podobnych im aktorów. W ich przypadku olbrzymi wpływ na przemysł 4.0 nie łączy się z zobowiązaniem do stosowania demokratycznych standardów, mających na względzie ochronę wolności i prywatności użytkowników technologii. Inni eksperci dodają, że w najbliższej dekadzie decydująca będzie rywalizacja między Stanami Zjednoczonymi a Chinami. To ona i związane z nią kalkulacje będą liczyć się bardziej niż względy etyczne i będą sterować rozwojem AI.

Kolejne zastrzeżenia wobec dzisiejszego porządku dotyczą monopolizowania rynku, koncentracji bogactwa i władzy w branży zajmującej się tworzeniem rozwiązań AI. Wielcy aktorzy w swoich działaniach, choć mogliby, nie muszą uwzględniać interesów użytkowników, a tym bardziej dobra wspólnego. Twórcy kierują się przede wszystkim zyskiem, interesami biznesowymi oraz logiką swoich inwestorów, a opinie użytkowników bywają uwzględnione post factum, o ile w ogóle zostaną przez nich skutecznie wyrażone. Tym bardziej istotne jest to w dziedzinie tak rozwojowej, nierozpoznanej i wiążącej się z wieloma niewiadomymi, w której wiele problemów jest jeszcze nieuświadomionych.

W odpowiedziach zwracano również uwagę na to, że obecnie jednym z podstawowych zastosowań AI jest to, by służyła przekonywaniu ludzi do konsumowania. Algorytmy skuteczniej niż tradycyjne metody marketingowe nakłaniają do kupowania bądź odbierania treści i produktów, których bez wpływu sztucznej inteligencji użytkownicy nigdy by nie dostrzegli lub nie chcieli pozyskać. O ile eksponowanie na nowe treści samo w sobie nie jest niczym złym, w praktyce skutek jest odwrotny, a skala nadużyć jest ogromna. Przez brak obostrzeń, marketing z zastosowaniem narzędzi sztucznej inteligencji staje się coraz bardziej nieetyczny, coraz częściej służy także przestępczości.

Jednym z proponowanych rozwiązań jest to, by projektanci UX [user-experience] kładli większy nacisk na kontrolę po stronie użytkownika nad proponowanymi rozwiązaniami i funkcjami. Fetyszyzacja wydajności, efektu skali oraz automatyzacji procesów są oceniane przez ekspertów jako błąd w dobie wzmagającej się tendencji do kwestionowania hiperzglobalizowanej i utowarowionej wersji porządku społeczno-gospodarczego.

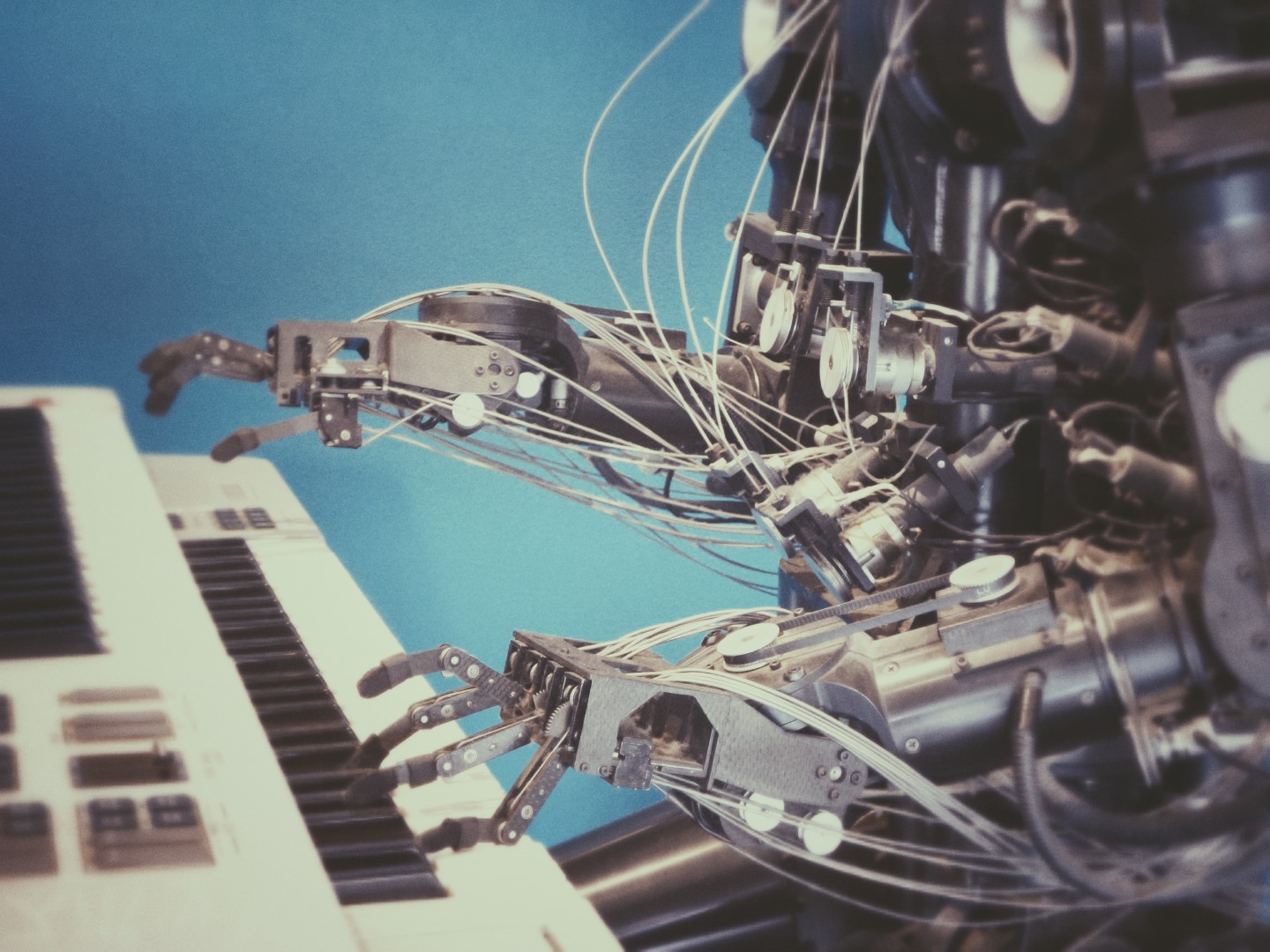

Photo by Possessed Photography on Unsplash

Dylematy: Co to znaczy „etyczne”? Kto o tym decyduje i czy można to egzekwować?

Twórcy raportu z badania wyróżnili wiele kwestii związanych z wątpliwościami i nadziejami dotyczącymi projektowania sztucznej inteligencji w perspektywie 2030 roku oraz próbami jej etycznego uregulowania.

Eksperci zwracają uwagę na to, że nie ma zgody co do wartości i w obecnych czasach trudno wyobrazić sobie powszechną zgodę co do tego, co miałoby być rozumiane jako „dobre” bądź „złe” i „niekorzystne”. W dobie polaryzacji i kwestionowania autorytatywnego decydowania o rozwiązaniach, wypracowanie konsensusu dotyczącego tego, kto i na jakiej podstawie ustala standardy w dziedzinie wolności, samo w sobie wymagałoby olbrzymich wysiłków.

Wobec nieprecyzyjnych kategorii etycznych i braku klarownych zasad, eksperci zwracają uwagę na możliwość, że każde narzędzie może być wykorzystane zarówno źle, jak i dobrze, w zależności od intencji i zasobności twórców oraz świadomości użytkowników. Trudno zatem jednoznacznie ustalić zasady.

Niepewność co do tempa i możliwości rozwoju technologii sprawiają, że również niełatwo stwierdzić, co będzie etyczne w przyszłości, a co nie – i co miałoby być podstawą do identyfikacji konieczności zmiany. Wymagałoby to zgody na niepewność i postępującą zmienność zasad – trudną do zaakceptowania przez biznes i obywateli. Sytuację zdaniem ekspertów dodatkowo komplikuje fakt, że wiele rozwiązań AI jest wdrażanych od lat, wobec czego trudno mówić o czystej karcie w decydowaniu o etycznych standardach. Nadużycia już się zdarzają, brak dziś obiektywnego kryterium do ich stwierdzania i niełatwo im zaradzić.

Na zadane ekspertom pytanie dotyczące niepokojów i wątpliwości związanych z rozwojem AI odpowiada również KACPER NOSARZEWSKI, ekspert 4CF i PTSP

|

W opiniach ekspertów pojawiają się także wątpliwości co do możliwości narzucenia obowiązujących regulacji, nawet gdyby zostały wypracowane, zarówno biznesowi i twórcom, jak i użytkownikom. Jeśli celem miałaby być wyłącznie opłacalność bądź efektywne działanie urządzeń, trudno o kompromis ze względu na wspólne dobro i tym podobne wartości. Według ekspertów w badaniu, obecnie kontrola nad AI jest skoncentrowana w rękach największych firm i rządów, które kierują się chęcią zysku i zdobycia władzy.

Odpowiedzialność za etyczne aspekty technologii związanych ze sztuczną inteligencją jest rozproszona. Należałoby uregulować rolę deweloperów, wytwórców i składaczy urządzeń, dystrybutorów oraz decydentów, zarówno w biznesie, jak i administracji, stworzyć przepisy dotyczące praw i obowiązków poszczególnych autorów, a także kontroli i nadzoru. Prócz zysku i cyberprzestępczości, istniejące narzędzia AI służą także do rozwijania państwowej bądź prywatnej infrastruktury służącej do inwigilacji, nadzoru i dezinformacji. Rezygnacja z podjęcia wyzwania uregulowania sektora czy bierność wobec nadużyć nie powinny być więc uznawane za możliwą do akceptowania normalność.

W czym upatrywać nadziei?

Eksperci są zgodni co do tego, że rozwój w dziedzinie sztucznej inteligencji jest nieunikniony, zwłaszcza że – według nich – realne możliwości sztucznej inteligencji i uczenia maszynowego są niedoszacowane. Dotyczy to głównie dziedzin wykraczających poza rozrywkę i konsumpcję, takich jak na przykład medycyna.

Wobec zaległości w tej sferze trzeba pracować nad tym, żeby dalszy rozwój AI podlegał standardom etycznym. W wypracowywaniu konsensusu pomóc mogą poprawiające transparentność rozwiązania open source’owe. Wielkie znaczenie będzie miał także nacisk coraz bardziej świadomych użytkowników, opinii publicznej i grup obywatelskich. Ich rolą byłoby sprawowanie nadzoru nad stanem dziedziny i rozwiązaniami, recenzowanie oraz wymaganie dodatkowych działań regulacyjnych od rządzących.

Na zadane w badaniu pytanie dotyczące nadziei związanych z rozwojem AI odpowiada poniżej KACPER NOSARZEWSKI, ekspert 4CF i PTSP.

|

Stopniowe zmiany, związane także z dojrzewaniem technologii, sprawią, że nieetyczne rozwiązania być może staną się nieopłacalne bądź nieakceptowalne dla kolejnych generacji użytkowników. Rosnąca świadomość co do zastosowań AI w szerzeniu dezinformacji, mowy nienawiści, w technologiach wojennych oraz infrastrukturze krytycznej czy medycynie, we wpływaniu na politykę czy wykluczaniu i kontrolowaniu obywateli, sprawia, że temat nowoczesnych technologii pojawia się jako przedmiot zainteresowania etyki. Uznawany jest także za istotny w oczach opinii publicznej. Cyberbezpieczeństwo i prywatność zyskują na ważności jako element interesu osobistego jednostek, a w skali społecznej i państwowej – stają się racją stanu. Hackowanie sztucznej inteligencji nie może być dopuszczalne, jeśli państwa mają utrzymać swoją niezależność i wypełniać swoje zobowiązania wobec obywateli.

Dla ekspertów jasne jest, że standardy etyczne są warunkiem bezpieczeństwa, aby je zagwarantować, sama etyka musi się rozwijać i ewoluować. A rozwój kolejnych pól zastosowania sztucznej inteligencji będzie wskazywał kierunki rozwoju etyki AI jako odrębnej dziedziny.

Podsumowanie – sztuczna inteligencja wciąż stanowi ryzyko

Epoka, w której sztuczna inteligencja dominuje życie codzienne społeczeństw – wbrew świadomości wielu osób – już staje się naszym udziałem. Wystarczy mieć w kieszeni smartfona, używać mediów społecznościowych i wyszukiwarek internetowych, aby w ciągu dnia mieć więcej kontaktu z maszyną niż z człowiekiem. Algorytmy decydują o tym, co oglądamy, co czytamy i kupujemy, a także o czym myślimy. Nie oznacza to wcale, że nasza codzienność już jest komputerową dystopią i wstępem do „Matrixa”, choć kolejne dziedziny, takie jak medycyna już otwierają się na nowe rozwiązania z dziedziny AI. Tym bardziej dyskusje nad etycznym projektowaniem sztucznej inteligencji – takie jak ta, prowadzona w omawianym raporcie – są niezwykle ważne. To od standardów oraz intencji twórców produktów, usług i kierujących nimi algorytmów zależy – i w coraz większym stopniu zależeć będzie – kształt naszej codzienności oraz nasze jednostkowe i społeczne bezpieczeństwo.